Kas yra „Robots.txt“ failas domene?

Žiniatinklio Valdytojo įrankiai Tinklalapiai Seo Herojus / / March 19, 2020

Paskutinį kartą atnaujinta

Viena didžiausių naujų svetainių savininkų klaidų yra nežvalgyti į savo robots.txt failą. Taigi, kas tai vis tiek, ir kodėl tokia svarbi? Mes turime jūsų atsakymus.

Jei jums priklauso svetainė ir jums rūpi jūsų svetainės SEO sveikata, turėtumėte gerai susipažinti su domeno robots.txt failu. Patikėkite ar ne, tai yra nerimą keliantis skaičius žmonių, kurie greitai paleidžia domeną, įdiegia greitą „WordPress“ svetainę ir niekada nesivargina nieko daryti su savo robots.txt failu.

Tai pavojinga. Prastai sukonfigūruotas failas robots.txt iš tikrųjų gali sunaikinti jūsų svetainės SEO būklę ir sugadinti visas jūsų galimybes padidinti srautą.

Kas yra „Robots.txt“ failas?

Robotai.txt failas yra tinkamai pavadintas, nes tai iš esmės yra failas, kuriame pateikiamos žiniatinklio robotų (pvz., paieškos variklių robotų) nurodymai, kaip ir ką jie gali nuskaityti jūsų svetainėje. Tai buvo žiniatinklio standartas, kurį internetinės svetainės seka nuo 1994 m., O visi pagrindiniai interneto tikrinimo įrenginiai laikosi šio standarto.

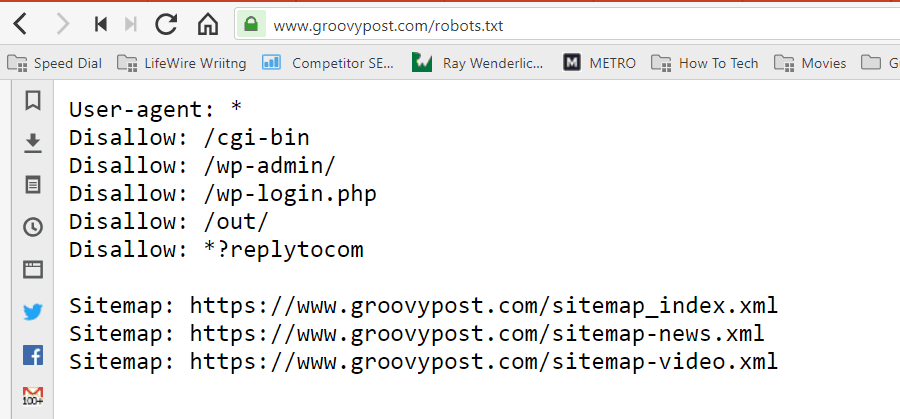

Failas saugomas teksto formatu (su .txt plėtiniu) jūsų svetainės šakniniame aplanke. Tiesą sakant, galite peržiūrėti bet kurios svetainės robot.txt failą tiesiog įvesdami domeną, po kurio eina /robots.txt. Jei išbandysite tai naudodami „groovyPost“, pamatysite gerai struktūruoto roboto.txt failo pavyzdį.

Failas yra paprastas, bet efektyvus. Šis failo pavyzdys neskiria robotų. Komandos visiems robotams išduodamos naudojant Vartotojo atstovas: * direktyva. Tai reiškia, kad visos komandos, vykdančios ją, taikomos visiems robotams, kurie lankosi svetainėje, norėdami ją aptikti.

Nurodykite interneto tikrinimo įrenginius

Taip pat galėtumėte nurodyti konkrečias taisykles, taikomas konkretiems interneto tikrinimo įrenginiams. Pvz., Galite leisti „Googlebot“ („Google“ žiniatinklio tikrinimo programa) tikrinti visus jūsų svetainės straipsnius, tačiau galbūt norėsite neleisti rusiškam interneto tikrinimo įrenginiui „Yandex Bot“ tikrinti jūsų svetainėje esančius straipsnius, kuriuose yra niekinančios informacijos apie Rusija.

Yra šimtai internetinių tikrinimo programų, kurios internete ieško informacijos apie svetaines, tačiau čia išvardytos 10 dažniausiai pasitaikančių problemų, kurios jums turėtų rūpėti.

- „Googlebot“: „Google“ paieškos variklis

- Bingbotas: „Microsoft“ „Bing“ paieškos variklis

- Pliurpti: „Yahoo“ paieškos variklis

- „DuckDuckBot“: Paieškos sistema „DuckDuckGo“

- Baiduspideris: Kinijos „Baidu“ paieškos variklis

- „YandexBot“: Rusijos „Yandex“ paieškos variklis

- „Exabot“: Prancūzijos „Exalead“ paieškos variklis

- „Facebot“: „Facebook“ tikrinimo robotas

- ia_archiver: „Alexa“ žiniatinklio reitingo tikrinimo programa

- MJ12bot: Didelė nuorodų indeksavimo duomenų bazė

Pažvelkite į aukščiau pateiktą scenarijaus pavyzdį, jei norėjote leisti „Googlebot“ indeksuoti viską savo svetainėje, bet norėjote neleidžiant „Yandex“ indeksuoti jūsų rusiško straipsnio turinio, prie robots.txt pridėtumėte šias eilutes byla.

Vartotojo agentas: googlebot

Neleisti: Neleisti: / wp-admin /

Neleisti: /wp-login.php

Vartotojo agentas: yandexbot

Neleisti: Neleisti: / wp-admin /

Neleisti: /wp-login.php

Neleisti: / rusija /

Kaip matote, pirmoji skiltis tik užkerta kelią „Google“ tikrinti jūsų „WordPress“ prisijungimo puslapį ir administracinius puslapius. Antrame skyriuje blokuojama ne tik „Yandex“, bet ir visa jūsų svetainės sritis, kurioje esate paskelbę straipsnių su antirusiška turiniu.

Tai yra paprastas pavyzdys, kaip galite naudoti Neleisti komanda, skirta valdyti konkrečius interneto tikrinimo įrenginius, kurie lankosi jūsų svetainėje.

Kitos „Robots.txt“ komandos

Neleisti yra ne vienintelė komanda, kurią turite prieigą prie savo robots.txt failo. Taip pat galite naudoti bet kurias kitas komandas, kurios nurodys, kaip robotas gali nuskaityti jūsų svetainę.

- Neleisti: Nurodo vartotojo agentui vengti nuskaityti konkrečius URL arba visas jūsų svetainės skiltis.

- Leisti: Leidžia patikslinti tam tikrus savo svetainės puslapius ar poaplankius, net jei galbūt neleidote pirminio aplanko. Pvz., Galite neleisti: / apie /, bet tada leisti: / apie / ryan /.

- Tikrinimo vėlavimas: Tai nurodo tikrinimo įrenginiui palaukti xx sekundžių skaičių prieš pradedant tikrinti svetainės turinį.

- Svetainės schema: Nurodykite paieškos variklius („Google“, „Ask“, „Bing“ ir „Yahoo“) savo XML svetainių schemų vietą.

Atminkite, kad robotai tai padarys tik klausykite komandų, kurias pateikėte, kai nurodote roboto pavadinimą.

Dažna klaida, kurią žmonės daro, yra neleisti tokių svetainių kaip / wp-admin / iš visų robotų, bet tada nurodykite „googlebot“ skyrių ir tik kitų sričių (pvz., Apie / apie) neleidimą.

Kadangi robotai vykdo tik komandas, kurias nurodote jų skyriuje, turite pakartoti visas tas kitas komandas, kurias nurodėte visiems robotams (naudodamiesi * vartotojo agentu).

- Neleisti: Komanda, naudojama vartotojo agentui nurodyti netirti konkretaus URL. Kiekvienam URL leidžiama tik viena eilutė „Neleisti:“.

- Leisti (taikoma tik „Googlebot“): Komanda „Googlebot“ pasakyti, kad ji gali pasiekti puslapį ar poaplanką, net jei jo pagrindiniame puslapyje ar poaplanke gali būti neleidžiama.

- Tikrinimo vėlavimas: Kiek sekundžių tikrinimo įrenginys turėtų palaukti prieš įkeldamas ir nuskaitydamas puslapio turinį. Atminkite, kad „Googlebot“ šios komandos nepripažįsta, tačiau tikrinimo greitį galima nustatyti „Google Search Console“.

- Svetainės schema: Naudojamas XML svetainės žemėlapio (-ių), susieto su šiuo URL, nustatyti. Atminkite, kad šią komandą palaiko tik „Google“, „Ask“, „Bing“ ir „Yahoo“.

Atminkite, kad robots.txt yra skirtas padėti teisėtiems robotams (pvz., Paieškos variklių robotams) efektyviau tikrinti jūsų svetainę.

Yra daugybė nemandagių tikrinimo programų, kurios tikrina jūsų svetainę, kad atliktų tokius veiksmus, kaip scrape el. Pašto adresus ar pavogti jūsų turinį. Jei norite pabandyti naudoti failą robots.txt, norėdami užkirsti kelią šiems robotams nuskaityti bet ką jūsų svetainėje, nesivaržykite. Šių tikrinimo programų kūrėjai paprastai nepaiso nieko, ką įdėjote į robots.txt failą.

Kodėl nieko neleisti?

Daugelio svetainių savininkams rūpi, kaip „Google“ paieškos varikliui aptikti kuo daugiau kokybiško turinio jūsų svetainėje.

Tačiau „Google“ išleidžia tik nedaug nuskaitymo biudžetas ir nuskaitymo greitis atskirose svetainėse. Tikrinimo greitis yra tai, kiek užklausų per sekundę „Googlebot“ pateiks jūsų svetainei tikrinimo įvykio metu.

Svarbiau yra nuskaitymo biudžetas, ty kiek „Googlebot“ pateiks visų užklausų aptikti jūsų svetainę per vieną seansą. „Google“ išleidžia savo tikrinimo biudžetą sutelkdama dėmesį į jūsų svetainės sritis, kurios yra labai populiarios arba neseniai pasikeitė.

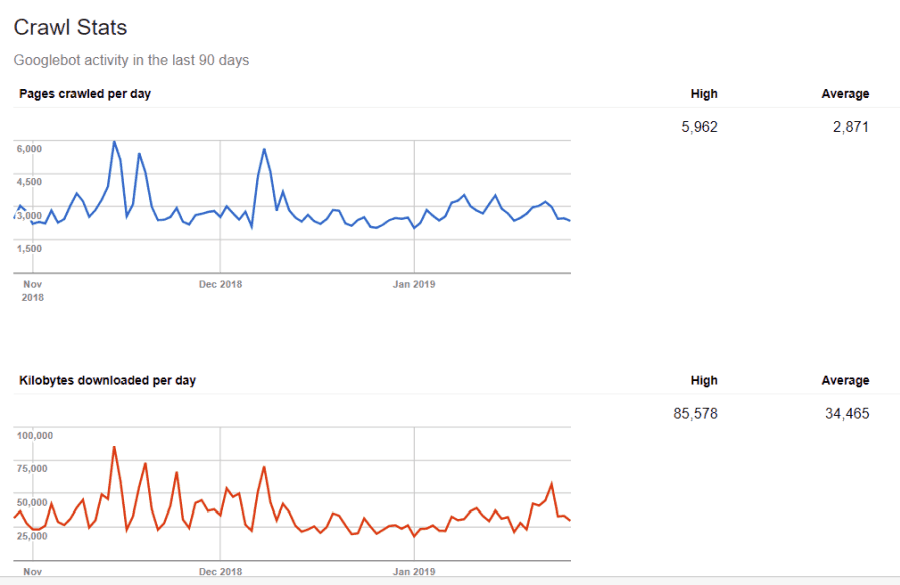

Jūs nematote šios informacijos. Jei lankysitės „Google“ žiniatinklio valdytojo įrankiai, galite pamatyti, kaip tikrinimo įrenginys tvarko jūsų svetainę.

Kaip matote, tikrinimo programa kasdien nuolatos vykdo veiklą jūsų svetainėje. Jis apžiūri ne visas svetaines, o tik tas, kurias laiko svarbiausiomis.

Kodėl „Googlebot“ gali nuspręsti, kas yra svarbu jūsų svetainėje, kai robots.txt failą galite naudoti norėdami pasakyti, kokie yra svarbiausi puslapiai? Tai neleis „Googlebot“ eikvoti laiko mažos vertės jūsų svetainės puslapiuose.

Tikrinimo biudžeto optimizavimas

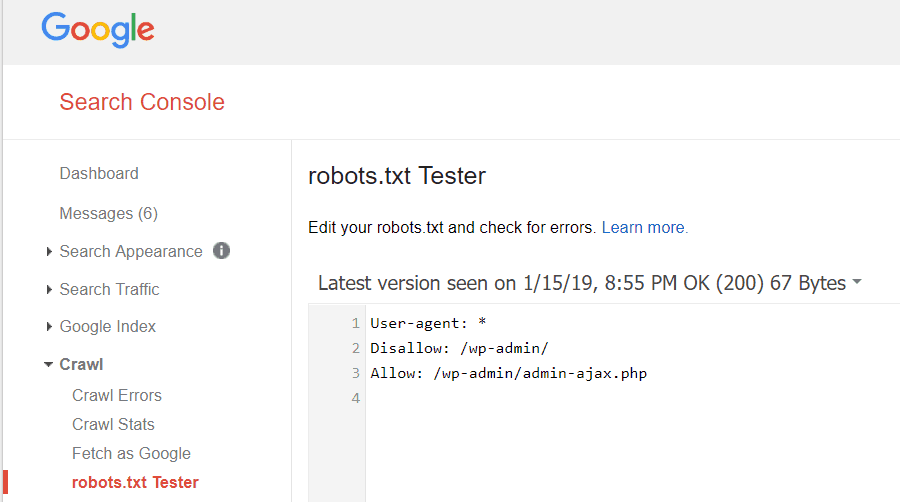

„Google“ žiniatinklio valdytojo įrankiai taip pat leidžia patikrinti, ar „Googlebot“ gerai skaito robots.txt failą ir ar nėra klaidų.

Tai padeda patikrinti, ar tinkamai robots.txt failą susisteminote.

Kokius puslapius turėtumėte atsisakyti „Googlebot“? Gerai, kad jūsų svetainės SEO neleidžia šių kategorijų puslapių.

- Puslapių kopijos (pvz., Tinkami spausdinti puslapiai)

- Dėkojame puslapiams, vykdantiems pagal formas pagrįstus užsakymus

- Užsakymo ar informacijos užklausų formos

- Kontaktiniai puslapiai

- Prisijungimo puslapiai

- Pagrindiniai „pardavimo“ puslapiai

Neignoruokite savo „Robots.txt“ failo

Didžiausia klaida, kurią daro naujieji svetainių savininkai, net nežiūri į savo robots.txt failą. Blogiausia padėtis gali būti ta, kad failas robots.txt iš tikrųjų užkerta kelią jūsų svetainei ar jos sritims tikrinti.

Nepamirškite peržiūrėti robots.txt failo ir įsitikinkite, kad jis optimizuotas. Tokiu būdu „Google“ ir kiti svarbūs paieškos varikliai „mato“ visus pasakiškus dalykus, kuriuos siūlote pasauliui savo svetainėje.